GPU là gì và có cần thiết trong Deep Learning?

Bất kỳ nhà khoa học dữ liệu hoặc những ai đam mê machine learning đều cố gắng khám phá hiệu suất của các mô hình đào tạo đôi khi sẽ đạt đến giới hạn và bắt đầu trải nghiệm các mức độ xử lý trễ khác nhau. Các nhiệm vụ mất vài phút với các bộ huấn luyện nhỏ hơn có thể mất nhiều giờ hơn – trong một số trường hợp vài tuần – khi các bộ dữ liệu trở nên lớn hơn. Điều họ cần là một cấu hình máy với bộ GPU cao.

Nhưng GPU là gì? Làm thế nào để họ xếp GPU lên CPU? Có cần thiết sử dụng GPU cho deep learning vào dự án của mình?

Nếu bạn đã từng thắc mắc vấn đề này, hãy cùng iRender đọc bài viết dưới đây…

Tại sao cần nhiều phần cứng hơn cho việc deep learning?

Đối với bất kỳ neural network nào, giai đoạn đào tạo mô hình deep learning là nhiệm vụ cần nhiều tài nguyên nhất

Trong khi đào tạo, một neural network nhận các input, sau đó được xử lý trong các lớp ẩn bằng cách sử dụng các trọng số được điều chỉnh trong quá trình đào tạo và mô hình sau đó đưa ra một dự đoán. Trọng lượng được điều chỉnh để tìm các mẫu để đưa ra dự đoán tốt hơn.

Cả hai hoạt động này về cơ bản là nhân ma trận. Phép nhân ma trận đơn giản có thể được biểu diễn bằng hình ảnh bên dưới

Trong một neural network, chúng ta có thể có array đầu tiên là input của neural network, trong khi array thứ hai tạo thành trọng lượng của nó.

Nếu neural network của bạn có khoảng 10, 100 hoặc thậm chí 100.000 tham số. Một máy tính vẫn có thể xử lý việc này trong vài phút hoặc thậm chí nhiều giờ nhất.

Nhưng nếu neural network của bạn có hơn 10 tỷ thông số thì sao? Sẽ mất nhiều năm để đào tạo loại hệ thống này sử dụng phương pháp truyền thống. Máy tính của bạn có thể sẽ bỏ cuộc trước khi bạn đi một phần mười chặng đường.

Sử dụng GPU cho Deep Learning để xử lý nhanh hơn

Các mô hình Deep Learning có thể được đào tạo nhanh hơn bằng cách đơn giản là chạy tất cả các hoạt động cùng một lúc thay vì lần lượt từng hoạt động.

Bạn có thể đạt được điều này bằng cách sử dụng GPU để đào tạo mô hình của bạn.

GPU (Bộ xử lý đồ họa) là bộ xử lý chuyên dụng với bộ nhớ chuyên dụng thực hiện các điểm nối cần thiết để kết xuất đồ họa

Nói cách khác, nó là bộ xử lý đơn chip được sử dụng cho các tính toán đồ họa và toán học mở rộng giúp giải phóng các chu kỳ CPU cho các công việc khác.

Sự khác biệt chính giữa GPU và CPU là GPU dành nhiều bóng bán dẫn tương ứng hơn cho các đơn vị logic số học, ít lưu trữ và điều khiển nhiều luồng hơn so với CPU.

Mặc dù CPU chủ yếu áp dụng cho các vấn đề yêu cầu phân tích cú pháp hoặc giải thích logic phức tạp trong mã, GPU được thiết kế để xử lý đồ họa chuyên dụng của trò chơi máy tính, và sau đó được cải tiến để tăng tốc các phép tính hình học khác (ví dụ: chuyển đổi đa giác hoặc xoay dọc vào các hệ tọa độ khác nhau như 3D).

GPU nhỏ hơn CPU nhưng có xu hướng có nhiều logical core hơn (đơn vị logic số học hoặc ALU, đơn vị điều khiển và bộ nhớ cache).

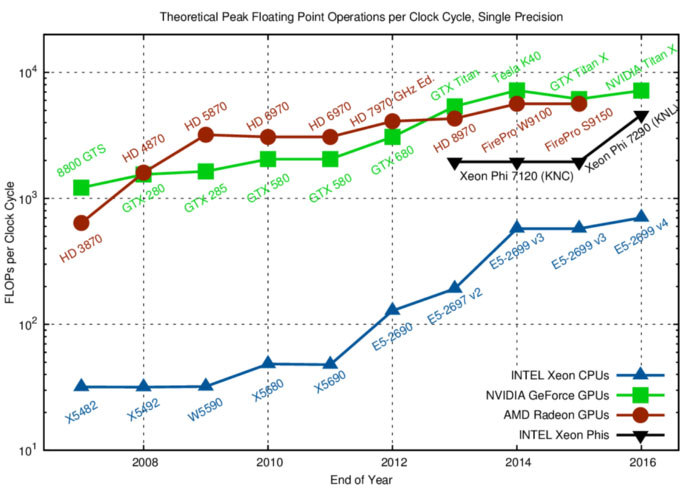

Trong biểu đồ trên, bạn có thể thấy rằng GPU (đỏ / xanh) về mặt lý thuyết có thể thực hiện 10 hoạt động 151515x của CPU (màu xanh lam).

Nếu bạn coi CPU là chiếc xe Maserati, GPU có thể được coi là một chiếc xe tải lớn.

CPU (Maserati) có thể lấy một lượng nhỏ các gói (3 -4 hành khách) trong RAM một cách nhanh chóng trong khi GPU (xe tải) chậm hơn nhưng có thể lấy một lượng lớn bộ nhớ (~ 20 hành khách) trong một lượt.

Tại sao nên chọn GPU cho Deep Learning thay vì CPU

GPU được tối ưu hóa để đào tạo trí tuệ nhân tạo và các mô hình deep learning vì chúng có thể xử lý đồng thời nhiều tính toán.

Chúng có số lượng core lớn, cho phép tính toán tốt hơn nhiều quy trình song song. Ngoài ra, các tính toán trong deep learning cần xử lý lượng dữ liệu khổng lồ – điều này làm cho băng thông bộ nhớ GPU luôn phù hợp nhất.

Có một vài tham số quyết định để xác định nên sử dụng CPU hay GPU để đào tạo mô hình deep learning:

Băng thông bộ nhớ:

Băng thông là một trong những lý do chính khiến GPU nhanh hơn cho máy tính so với CPU. Với bộ dữ liệu lớn, CPU chiếm rất nhiều bộ nhớ khi đào tạo mô hình.

Việc tính toán các công việc khổng lồ và phức tạp chiếm rất nhiều chu kỳ xung nhịp trong CPU – CPU đảm nhận các công việc tuần tự và có số lượng core ít hơn so với GPU.

Mặt khác, GPU độc lập đi kèm với bộ nhớ VRAM (Video RAM) chuyên dụng. Do đó, bộ nhớ CPU có thể được sử dụng cho các tác vụ khác.

Kích thước bộ dữ liệu

Đào tạo một mô hình trong deep learning đòi hỏi một bộ dữ liệu lớn, từ đó cần các hoạt động tính toán lớn về bộ nhớ. Để tính toán dữ liệu hiệu quả, GPU là một lựa chọn tối ưu. Các tính toán càng lớn, lợi thế của GPU so với CPU càng nhiều.

Tối ưu hóa

Tối ưu hóa các tác vụ dễ dàng hơn nhiều trong CPU. Các core CPU, mặc dù ít hơn, nhưng mạnh hơn hàng ngàn core GPU.

Mỗi lõi CPU có thể thực hiện theo các hướng dẫn khác nhau (kiến trúc MIMD) trong khi đó, các core GPU, thường được tổ chức trong các khối 32 core, thực hiện cùng một lệnh tại một thời điểm nhất định (kiến trúc SIMD).

Sự song song trong các neural network dày đặc là rất khó khăn với nỗ lực mà nó đòi hỏi. Do đó, các kỹ thuật tối ưu hóa phức tạp khó thực hiện trong GPU hơn trong CPU.

Qua bài viết trên, chúng ta có thể thấy được tầm quan trọng của GPU trong deep learning lớn thế nào. iRender ở đây để đưa sức mạnh GPU Cloud đến trực tiếp đến bàn làm việc của bạn. Giảm tải cho máy tính của bạn bằng cách di chuyển mọi tác vụ Build & Train & Tune dự án AI/DeepLearning lên GPU Cloud của chúng tôi. Chỉ 5-10 click để bắt đầu sở hữu sức mạnh GPU Server của bạn ngay lập tức. Tìm kiếm tự do và niềm vui công việc với sức mạnh GPU Cloud trong chính máy tính cá nhân của bạn.

Tìm hiểu thêm 6 ứng dụng Deep Learning thú vị cho NLP

Nguồn từ tác giả: Jason Dsouza